Erfolgreich beobachtet

Im Jahr 2016 sorgte der Chatbot „Tay“ für große Aufmerksamkeit. Als lernfähige KI sollte er im Dialog mit Twitter-Usern seine Kommunikationsfähigkeiten verbessern. Dabei übernahm er aber schnell diskriminierende und fremdenfeindliche Äußerungen. Das System musste daraufhin nach nur weniger als einem Tag außer Betrieb genommen werden.

Neun Jahre später und ein paar Entwicklungsstufen weiter, war ironischerweise die gegenteilige Reaktion zu bemängeln. Anwender des Chatbots ChatGPT beklagten einen zu netten Charakter, der fragwürdige Überzeugungen leichtfertig unterstützt haben soll. Auch hier musste der Anbieter nach nur wenigen Tagen nachbessern, um das Verhalten der KI zu korrigieren.

In beiden Vorfällen hinterfragte die User-Community die Ausgaben und Ergebnisse der KI kritisch und zweifelte die Rechtmäßigkeit der Funktionsweise an. Erst die Überwachung der Nutzer eröffnete schließlich die notwendige Korrektur durch die Entwickler.

Warum müssen KI Systeme überwacht werden?

Die Beispiele zeigen eindrucksvoll, was die Europäische Kommission auch schon bei Erlass der KI-Verordnung (KI-VO) als hinreichend notwendig erachtete: Systeme künstlicher Intelligenz bedürfen menschlicher Überwachung. Zumindest für Applikationen bei denen hohe Risiken für Gesundheit, Sicherheit und Grundrechte zu erwarten sind, ist dieser Leitgedanke im Artikel 14 der KI-VO festgesetzt worden. Dem gemäß müssen Hersteller Mensch-Maschine-Schnittstellen implementieren, die eine operative Aufsicht von qualifiziertem Personal ermöglichen.

Als Erwägungsgründe für die menschliche Aufsicht wurden zum einen die Verbesserung der Leistung und Sicherheit der KI durch den Menschen gesehen; zum anderen solle dies aber auch die Rechenschaftspflicht, menschliche Autonomie und Handlungsfähigkeit fördern.

Grundzüge dieser Überlegungen finden sich auch in den derzeit international vorangetriebenen Standardisierungs- und Normierungsprozessen wieder. Aktuelle Entwürfe des globalen Normungsgremiums ISO/IEC heben dabei die technischen Ursachen für die Problematik hervor: KI-Systeme sind gerade deswegen fehleranfällig, weil nicht alle Testfälle beim Erstellen der Software abgedeckt werden können. [1] Deshalb funktionieren die zum Teil hoch automatisiert arbeitenden KI-Lösungen nicht immer so, wie es von seinen Entwicklern beabsichtigt ist. Wenn also nicht der gesamte Ergebnisbereich vorhergesagt werden kann, können beim Einsatz der Anwendungen unbekannte Neben- und Folgewirkungen festgestellt werden. Diese werden aber in erster Linie erst im späteren Verlauf von Anwendern während der Nutzung festgestellt.

Methoden menschlicher Aufsicht

Mechanismen zur Überwachung von Maschinen können vereinfacht in zwei Gruppen eingeteilt werden. Die bereits in der Luftfahrt etablierte Methode des „Human-in-the-Loop“ wird eingesetzt, um Maschinen während des Betriebs zu überwachen. Antworten des laufenden Systems werden dabei vom Bediener parallel bewertet und korrigiert. Besonders effektiv ist das sogenannte „Reinforcement Learning with Human Feedback“ (RLHF), bei der die menschliche Rückmeldung direkt in die Optimierung der Anwendung einfließt. Eingriffe können dabei entweder in Echtzeit erfolgen oder auch im Anschluss durch nachträgliche Bewertung der Entscheidungen des Systems. Die Methodik zielt auf unmittelbare Eingriffsmöglichkeit in Einzelfälle ab, bei denen die Entscheidungen direkt von Menschen geprüft, bestätigt, abgelehnt oder gestoppt werden können.

Hingegen umfassender ist die Perspektive des „Human-on-the-Loop“. Sie richtet sich auf die systematische Überwachung kumulierter Daten über längere Zeiträume hinweg, um langfristige Muster zu erkennen und Fehlentwicklungen im KI-System entgegenwirken zu können. Zu diesem Zweck werden aggregierte Informationen zum Systemverhalten, Fehlerhäufigkeiten und Rückmeldungen in regelmäßigen Abständen ausgewertet.

KI – Cockpit – ein Projekt mit Praxisnähe

Im vom Bundesministerium für Arbeit und Soziales (BMAS) geförderten Projekt „KI-Cockpit“ wurde die Aufsichtsfunktion noch umfassender interpretiert. [4] Mit dem Konzept des „Human-in-Command“ soll die menschliche Aufsicht bereits in der Designphase partizipativ einfließen. Ziel des Projektes war die Entwicklung einer universellen Open Source Software zur Überwachung verschiedenartiger Systeme künstlicher Intelligenz. Getestet wurde der Einsatz in der Verkehrsüberwachung, bei der Unterstützung von Pflegepersonal sowie an einem System zur Personal-Auswahl. Abseits des eigentlichen „Performance Monitoring“ lag der Fokus auch auf der individuellen Anpassung der Software mittels kontextspezifischer Autonomiestufen. Mit dem Grad der Autonomie soll eingestellt werden können, in welchem Umfang das KI-System Handlungen vorbereitet und ab welchem Punkt der Mensch interveniert.

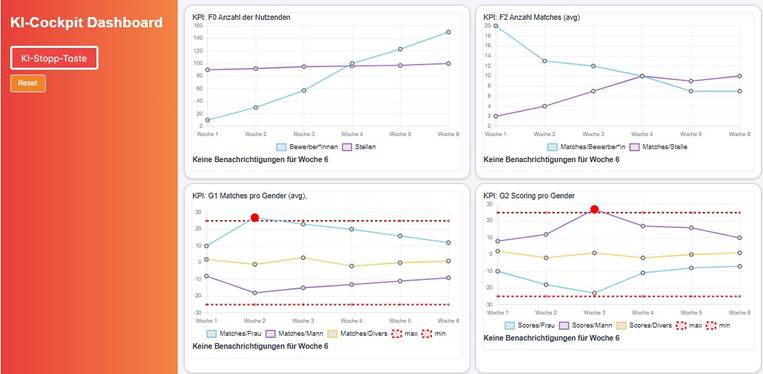

Der Prototyp des entwickelten KI-Cockpits wurde als interaktives Dashboard umgesetzt. Appliziert auf das Beispiel einer KI-gestützten Personalauswahl können damit Übersichten wie in der nebenstehenden Abbildung generiert werden.

Abbildung 1: Beispielansicht des „KI-Cockpit“ in der Anwendung zur Überwachung eines KI-gestützten Personalauswahlsystems [Quelle: Chemistree]

Die visuelle Schnittstelle beinhaltet auch die gemäß der europäischen KI-Verordnung geforderte Stopptaste für Hochrisiko Systeme. Dem Bediener soll damit die Möglichkeit gegeben werden, das System während des Betriebs zu unterbrechen, um somit unverzüglich potenziellen Schaden im Fehlerfall abwenden zu können.

Rückblickend sind im Projekt nicht nur alle gesetzlichen Anforderungen und aktuellen wissenschaftlichen Erkenntnisse berücksichtigt worden, sondern ebenso der interdisziplinäre Aspekt. Dabei wurde auch der betrieblichen Mitbestimmung eine Stimme im Beirat in Persona von Dietmar Kuttner vom Gesamtbetriebsrat der Siemens AG gegeben.

Anforderungen und Risiken bei der Aufsicht

Hinter der augenscheinlich simplen Oberfläche verbergen sich jedoch einige Herausforderungen. Bereits 1983 erkannte Lisanne Bainbridge die Ironie der zunehmenden Automation: Automatische Steuerungssysteme werden gerade deshalb installiert, weil sie die Arbeit besser erledigen als der Operator. Gleichzeitig wird von diesem aber verlangt, zu überwachen, ob die Algorithmik effektiv arbeitet. Offensichtlich sei also das Problem mit der Computerhilfe ein multidimensionales – wobei ironischer Weise der Beitrag des menschlichen Bedieners entscheidender wird, je fortschrittlicher das System ist. [2]

Und die Anforderungen an das Aufsichtspersonal von avancierten KI-Systemen sind in der Tat hoch. Eine zentrale Rolle spielt immer das passende Situationsbewusstsein. Die sogenannte „Situation Awareness“ beschreibt die Fähigkeit des Menschen, Umgebung und Umstände ausreichend wahrzunehmen und adäquat zu reagieren. Darüber hinaus muss bei Echtzeitüberwachungen eine hohe Konzentration über eine lange Zeit hinweg aufrechterhalten werden. Nach monotonen Überwachungsphasen soll in kritischen Situationen mitunter schnell und präzise entschieden werden. Dazu bedarf es eines guten Verständnisses des Systemkontext und einer sicheren Urteilskraft.

Bekanntermaßen weichen Menschen aber oft falsch von algorithmischen Empfehlungen ab. [3] Zudem gibt es mehrere weitere Einflussfaktoren, die Menschen zu einer Fehleinschätzung verleiten können. Einige der Phänomene sind in der nebenstehenden Tabelle gelistet.

| Risikofaktor | Beschreibung |

| Über- und Unterforderung | Eine zu hohe Informationsdichte kann kognitive Überlastung auslösen. Umgekehrt führen monotone oder wenig fordernde Aufgaben zur Ermüdung. Beides erhöht die Fehlerwahrscheinlichkeit bei der Überwachung. |

| Begrenzte Wahrnehmung | Ungenauigkeiten oder unfaire Entscheidungen automatisierter Systeme bleiben aufgrund systematischer Schwächen unerkannt. Komplexe Entscheidungswege und hohe Verarbeitungsgeschwindigkeit erschweren die Nachvollziehbarkeit. |

| Automatisierungsverzerrung (automation bias) | Ergebnisse automatisierter Systeme werden unkritisch akzeptiert. Auch bei widersprüchlichen Informationen wird oft den Empfehlungen der Automatisierung gefolgt. |

| Auslassungsfehler (algorithm aversion) | Notwendige Maßnahmen bleiben aus, wenn das System keine Warnung gibt. Umgekehrt werden fehlerhafte Empfehlungen befolgt, trotz gegenteiliger Hinweise oder korrekte algorithmische Vorschläge abgelehnt. |

| Aufmerksamkeitsverschiebung | Der Fokus richtet sich unbewusst auf die Aspekte, die vom System hervorgehoben werden. Relevante Zusatzinformationen geraten in den Hintergrund. |

Tabelle 1: Einflussgrößen für Fehleinschätzungen und Aufmerksamkeitsverluste bei der Aufsichtsperson eines automatisierten Systems

Den situativen Risiken gesellen sich zudem auch prekäre Tendenzen bei. Algorithmusbasierte Systeme werden mithin als Gefahr für menschliche Entscheidungsautonomie angesehen. Unter der Annahme einer zunehmenden Arbeitsverdichtung wird Aufsehern in der betrieblichen Praxis die Zeit fehlen, sich in jeder Situation ein fundiertes Urteil bilden zu können. Und damit wirft sich die weiterführende Frage der Verantwortung auf: Wenn die Verantwortung für Entscheidungen unklar ist, ist auch menschliche Aufsicht nicht mehr möglich.

Kompetenzaufbau als beste Lösung

Als effektivster Ausweg wird daher auch in den aktuellen Normungsvorhaben ein Kompetenzaufbau angesehen. [1] Voraussetzung für eine sinnvolle menschliche Aufsicht ist das Verständnis der Vorgänge und Ergebnisse der zu überwachenden Applikation. Aufsichtspersonen benötigen allgemeines Wissen über die Risiken des Systems, Wissen über Vorurteile im Zusammenhang mit KI sowie Verständnis der Kapazitäten und Beschränkungen des Zielsystems. Erklärbarkeit, Interpretierbarkeit und Transparenz werden daher als Schlüssel einer effektiven menschlichen Kontrolle genannt. Um Verzerrungen bei der Interaktion zwischen menschlichen Bedienern und KI-Systemen zu verringern, kommt auch die Normung zum Schluss, dass der menschliche Bediener vermehrt im kritischen Denken geschult werden muss.

Mit Überblick mitgestallten

Überwachung künstlicher Intelligenz ist angesichts der Herausforderungen nicht nur die Aufgabe einer einzelnen Person, sondern eine kollektive. Weitaus wichtiger als die Überprüfung von numerischen Tendenzen eines KI-Systems ist laut Dietmar Kuttner die gemeinsame Beobachtung der Wirkung auf Arbeit per se. Im Verbund eines Betriebsratsgremiums kann zusammen der Fokus geschärft und Fehler heterogener evaluiert werden. Dazu müssen Betriebsräte zum einen Einblicke in die laufende Überwachung erhalten und zum anderen auch „on the Loop“ sein. Um die komplexen Systeme in Gänze zu überschauen, bedarf es erweiterter Fachkenntnisse und ordentlicher Qualifikation

Daneben ist eine weitere fachlich – wissenschaftliche Auseinandersetzung mit dem Thema auf gesellschaftlicher Ebene unabdingbar. Entscheidende Beiträge kann auch die aktive Mitbestimmung liefern, um Beschäftigten und Betroffenen dabei eine Stimme zu geben. Damit behält man es selbst in der Hand, ob und wie eine KI kontrolliert werden muss.

Quellen

[1] Normentwurf der ISO/IEC CD 42105 : “Information technology — Artificial intelligence — Guidance for human oversight of AI systems”; 2025

[2] Lisanne Bainbridge; „Ironies of Automation“; 1983

[3] Ben Green; „Die Mängel von Richtlinien, die eine menschliche Aufsicht über Regierungsalgorithmen erfordern“; 2022

[4] siehe https://www.kicockpit.eu/