KI richtig einschätzen – keine einfache Aufgabe

In seinen drei Kritiken brachte es Immanuel Kant einst so zur Verwahrung: „Das Urteil ist also die mittelbare Erkenntnis eines Gegenstandes, mithin die Vorstellung einer Vorstellung desselben. … Urteilskraft überhaupt ist das Vermögen, das Besondere als enthalten unter dem Allgemeinen zu denken.“ [1]

Was Kant zur Urteilskraft ausführt, mag schwer verständlich erscheinen – nicht minder komplex gestaltet sich für Mitbestimmungsgremien die Bewertung künstlicher Intelligenz. Oftmals sind die Informationen unübersichtlich und vieldimensional für eine prägnante, sachgerechte Einordung. Praktisch ergibt sich daraus die Frage, welche Prüftiefe es für die verschiedenen Aspekte erfordert, um zu einem tragfähigen Urteil zu gelangen. Häufig mangelt es an der nötigen Zeit für eine erschöpfende Analyse.

Eine Orientierungshilfe soll daher die nachfolgende Abhandlung geben, die sich einem effektiven Evaluierungsprozess widmet, der sich an den rechtlich – normativen Standards orientiert.

Zur speziellen Charakteristik von KI

Unterschiede von klassischen IT-Lösungen und Systemen künstlicher Intelligenz sind mannigfaltig und prägen daher auch das Verfahren der sachlichen Beurteilung.

Zweckdienlich erweist sich die Betrachtung von KI als sogenannte „semiotische Maschine“. Eine „semiotische Maschine“ – d.h. eine zeichenverarbeitende Maschine -kann als Pendant zu einer stoff- bzw. energieumwandelnden Maschine angesehen werden [2]. Als Besonderheit wird KI gern der Charakter einer lernenden Maschine zugesprochen, die sich während des Betriebs anpasst, also ein sich veränderndes Werkzeug repräsentiert. Sie stellt also oftmals kein fertiges Produkt dar, weshalb Änderungen am System auch wiederkehrend bewertet werden müssen.

Bei einer Einschätzung von KI reicht es aber nicht aus, sich lediglich dem Arbeits- und Gesundheitsschutz zu widmen oder aus IT-Perspektive dem Datenschutz beziehungsweise der Leistungs- und Verhaltenskontrolle.

Künstliche Intelligenz hat erweiterte Optionen, in die menschliche Autonomie einzugreifen, menschliche Entscheidungsfindung zu ersetzen oder Persönlichkeitsrechte auf nicht unmittelbar ersichtliche Weise zu berühren. Daraus resultiert beispielsweise auch die „schwer überschaubare Vielfalt von qualitätsrelevanten Normen, Vorgaben und Qualitätsmerkmalen“ [3].

Den KI-Risiken auf der Spur

In der Tat ergibt sich eine Vielzahl unüberschaubarer Normen und Standardisierungsentwürfe im internationalen Bereich. Zudem entkoppelt sich die EU mit einem europäischen Weg zunehmend von der internationalen Standardisierung. Die harmonisierten Standards zur KI -Verordnung (KI-VO) werden sich schon in Grundnormung bezüglich Qualitäts- und Risikomanagementsystem von internationalen Entwürfen wie der ISO 42001 unterscheiden [4]. Aufgrund oben genannter Unterschiede bekommt die KI-Normung auch andere Grundlagen als die Richtlinien für konventionelle IT-Softwareprogramme. So wird zum Beispiel Risikomanagement bei KI-Systemen stärkere Anlehnung an Standards wie dem ISO 14971 für Medizingeräte finden.

Übergeordnet unverändert bleibt die verbreitete Auffassung der Definition eines Risikos als Kombination aus der Wahrscheinlichkeit und Schweregrad eines Schadens (z.B. ISO/IEC Guide 51). Alternativ interpretiert verkörpert es die Auswirkung von Unsicherheit auf Ziele (z.B. ISO 31000). Der neuen KI-Norm ISO/IEC 25059 folgend, kann „Freiheit von Risiken“ auch als Qualitätsmerkmal eines Produktes gelten.

Abseits geplanter Vereinfachungen werden normative Vorgaben für Hersteller von KI-Produkten umfangreich bleiben. Daraus ergeben sich mitunter zeitaufwändige und komplizierte Beurteilungsprozesse. Bei der Analyse von Risiken wendet man sich zum Beispiel umfassend den potenziellen Schäden mitsamt deren Schadenshöhe, Eintrittswahrscheinlichkeiten und Mitigationsmöglichkeiten zu. Kernschritte einer standardisierten Risikobewertung umfassen unter anderem:

- Risiko-Identifikation & Analyse

- Risikoschätzung & Bewertung

- Festlegung von Risikominderungsmaßnahmen

- Beschreibung von Restrisiken

- Validierung und Dokumentation

- Monitoring nach Markteinführung

Die einzelnen Schritte sind in dem Ablaufdiagramm gem. Abbildung 1 versinnbildlicht.

Abbildung 1: Prozess einer Risikobewertung in Anlehnung an ISO 31000

Solch aufwändige Verfahren werden von den sogenannten „Inverkehrbringern“ aber nur bei Hochrisikoanwendungen abverlangt. Demgegenüber können aber KI-Systeme auch nennenswerte Risiken in sich bergen, ohne gemäß der EU-Verordnung als Hochrisiko eingestuft sein zu müssen. Insbesondere fand die Wirkung von KI auf Arbeit und Beschäftigung weniger Beachtung beim Erlass der Produktverordnung. Analog der „Öffnungsklausel“ für individuelle Regelungen gemäß Art. 2 Abs 11 der KI-VO steht es daher frei, andere Ansätze mit differenziertem Risikofokus in Anwendung zu bringen.

Ansatz eines pragmatischen Verfahrens

Sofern eine Risikobewertung konform zur technischen Normung im konkreten Fall vorliegt, können daraus durchaus interessante Aspekte abgeleitet werden. Denn nebst vielen diversen technischen Risiken in Bereichen der Stabilität, Robustheit, Datenqualität, Veränderlichkeit oder auch Cybersecurity, widmet sich die Standardisierung übergeordnet den Risiken für Gesundheit, Sicherheit und Grundrechteverletzung. Die Herkunftsquellen von Risiken werden derzeit unter anderem auch von wissenschaftlichen Einrichtungen zusammengetragen. Erwähnt sei hier stellvertretend die Auflistung des MIT mit soziologischen und gesellschaftlichen Betrachtungshorizont [5].

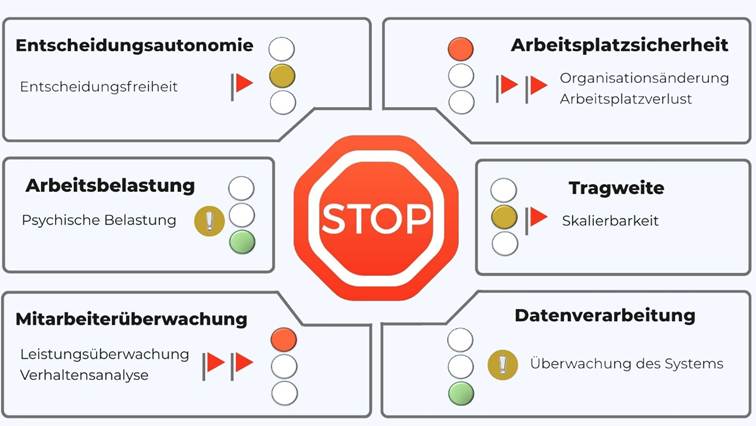

Für Mitbestimmungsgremien zählen dagegen Auswirkungen auf die Beschäftigten und deren Arbeitsbedingungen. Aus diesem Blickwinkel ergeben sich insbesondere folgende Dimensionen für eine erste Risikoabschätzung:

Tragweite: Zur übergeordneten Bedeutung der Anwendung kann z.B. abgeschätzt werden, wie viele Mitarbeiter betroffen sind und ob deren Kompetenzen auf- oder abgewertet werden.

Arbeitsplatzsicherheit: Wesentlich sind hierbei die Entwicklung der Qualifikationsanforderungen oder aber auch die sozialen Auswirkungen auf die Organisation.

Arbeitsbelastung: Arbeitsverdichtung oder Stressreduktion, Beibehaltung von Gestaltungsspielräumen oder auch die Umgestaltung der Tätigkeiten können sich belastend auswirken.

Datenverarbeitung: Fragen der Überwachungsform des Systems im Zusammenhang mit dessen Benachteiligungsrisiken werden bei der Bewertung der Verarbeitung von Daten durch KI nachgegangen.

Des Weiteren sind die klassischen Dimensionen mit KI spezifischer Charakteristik zu erkunden: Datenschutz, Mitarbeiterüberwachung und weiterführend Entscheidungsautonomie. Diese Basiskriterien sind sehr empfehlenswert, obgleich sie nicht als abschließend oder allgemeingültig einzustufen sind. Vielmehr ergeben sich die Faktoren auch aus den individuellen Umständen im Unternehmen beziehungsweise der Organisation.

Eine beispielhafte Auswertung einer Risikoabschätzung ist in Abbildung 2 dargestellt.

Abbildung 2: beispielhaftes Ergebnis einer Risikoabschätzung einer KI-Applikation

Risikoabschätzung mit angepasstem Prozess

Um Risiken angemessen abschätzen zu können, bedarf es eines angepassten Prozesses. Dieser muss so ausgeführt sein, dass er sich als kontinuierliches Prüfungsverfahren gegebenenfalls auch mehrfach über den Lebenszyklus eines KI-Systems durchführen lässt.

Als Voraussetzung müssen nicht nur die zweckmäßigen Informationen vorliegen, sondern die Unterrichtungsdokumente auch gezielt bewertungsorientiert ausgeführt sein. Hilfreich sind hierbei zielführende Fragen zur Einschätzung der Kritikalität in den verschiedenen Dimensionen. Sobald die Vorstellung und Angaben vom Arbeitgeber als ausreichend betrachtet werden, kann die erste Bewertung etwa durch eine Gruppe ausgewählter Mitglieder des zuständigen Gremiums vorgenommen werden.

Abgeschätzt wird nun, ob in der jeweiligen Kategorie ein niedriges, mittleres oder hohes Risiko vorliegt. Bewährt hat sich dabei eine numerische Skala, wobei zur Vereinfachung eine Eintrittswahrscheinlichkeit nicht explizit vergeben werden muss. Bei dieser pragmatischen Herangehensweise treten in der Diskussion häufig Chancen neben Risiken. Von Bedeutung sind hier aber nur mögliche Schäden oder negative Auswirkungen – denn darauf zielt eine Risikobewertung schließlich ab. Mit diesem Fokus lassen sich sämtliche Klassifizierungen vornehmen und mit ergänzenden Bemerkungen dokumentieren. Bei Neuvorlage bleibt die ursprüngliche Analyse dadurch nachvollziehbar und kann folge dessen leichter modifiziert werden.

Im Nachgang gilt zu prüfen, wo weiterer Klärungsbedarf besteht, beziehungsweise erhöhte Risiken vermutet werden („rote Flaggen“). Auch die Notwendigkeit einer Datenschutzfolgeabschätzung oder Gefährdungsbeurteilung kann sich im Anschluss der Begutachtung erhärten. Bestehen keine betriebsinternen Vorgaben zu deren Durchführung, ermöglicht die Risikoabschätzung eine belastbare Einschätzung ihrer Unabdingbarkeit.

Vorzüge prägnanten Urteilens

Insgesamt zeichnet sich die geschilderte Vorgehensweise durch pragmatische Vorteile aus. Eine kompakte Unterrichtung verhindert langwierige Klärungsprozesse zu Beginn und entlastet den Arbeitgeber bei der Entscheidung, welche Unterlagen in welchem Detailgrad bereitzustellen sind. Wiederholbarkeit und transparente Dokumentation erleichtern darüber hinaus die Nachvollziehbarkeit bei späteren Modifikationen an der Applikation. Gleichzeitig lassen sich aufgrund der Einfachheit flächendeckend sämtliche neu einzuführenden Systeme einschätzen. Zudem kristallisieren sich schon frühzeitig konkrete applikationsspezifische Handlungsbedarfe heraus.

Demgegenüber bedarf es aber etwas Erfahrung in der sachgerechten Einordnung vielfältiger Informationen, die je nach Anwendung sehr unterschiedlich ausfallen können. Man kann auch von einer Kompetenzerweiterung sprechen, die ein tieferes Beurteilungsverständnis aus wenigen Angaben charakterisiert. Ein Mitbestimmungsgremium, das diese Fähigkeit erwirbt, kann dann aber auch stets das Besondere im Allgemeinen auffinden.

Quellenangaben

[1] Kant, Immanuel. »Drei Kritiken: Kritik der reinen Vernunft + Kritik der praktischen Vernunft + Kritik der Urteilskraft«. 1781-1790

[2] Brödner, Peter. »Künstliche Intelligenz«: Dichtung und Wahrheit. 2023

[3] Lothar Schröder / Petra Höfers. »Praxishandbuch Künstliche Intelligenz«. BUND Verlag, 2022

[4] vgl. Normungsentwürfe prEN 18286, prEN 18228

[5] siehe MIT AI Risk Repository – https://airisk.mit.edu/