Vertrauenswürdigkeit im Kontext künstlicher Intelligenz

„Der zugrundeliegende Leitgedanke einer „vertrauenswürdigen KI“ ist zunächst schon mal begrifflicher Unsinn.“ [1] Thomas Metzinger, Philosoph und Mitglied der „High Level Expert Group on AI“ fand bereits 2019 deutliche Worte der Kritik am Arbeitsergebnis der „Ethischen Leitlinien für eine vertrauenswürdige KI“ [2]. Was die EU ursprünglich unter „Vertrauenswürdigkeit“ verstand, ist in sieben Prinzipien zusammengefasst (siehe Tabelle).

Dieser ethischen Betrachtung wurde schließlich die Begrifflichkeit einer „vertrauenswürdigen künstlicher Intelligenz“ in der KI-Verordnung entlehnt. Bei kritischer Betrachtung kann man aber durchaus zum Schluss kommen, dass das Gesetz „Vertrauenswürdigkeit“ mit der Akzeptanz von Risiken vermischt [3]. Schließlich diene die Betonung der Vertrauenswürdigkeit dem strategischen Zweck, Menschen dazu zu bewegen, Vertrauen in KI zu setzen, um das wirtschaftliche und soziale Potential zu erschließen.

| Kriterium | Erklärung |

| Vorrang menschlichen Handelns und menschliche Aufsicht | KI-Systeme sollen den Menschen befähigen, nicht ersetzen; sie müssen kontrollierbar sein; Menschen müssen im Entscheidungsprozess eingreifen können. |

| Technische Robustheit und Sicherheit | Das System muss widerstandsfähig gegenüber Fehlern, Angriffen oder unerwarteten Eingaben sein. |

| Schutz der Privatsphäre und Datenqualitätsmanagement | Personenbezogene Daten müssen geschützt werden. Zugrundeliegende Datensätze sollen qualitativ hochwertig, vollständig, korrekt und repräsentativ sein. |

| Transparenz | Mechanismen einer KI müssen nachvollziehbar sein; ausreichende Informationen und Erklärungen müssen für den Benutzer zur Verfügung stehen |

| Vielfalt, Nichtdiskriminierung und Fairness | KI-Systeme sollen Diskriminierung vermeiden, inklusiv sein und möglichst für unterschiedliche Gruppen „gerecht“ funktionieren. |

| Gesellschaftliches und ökologisches Wohlergehen | KI sollte dem Gemeinwohl dienen, negative gesellschaftliche oder ökologische Folgen minimieren und positiven Beitrag leisten. |

| Rechenschaftspflicht | Verantwortliche Personen, wie z.B. Hersteller müssen rechenschaftspflichtig sein, d. h. ihre Systeme müssen überprüfbar und Entscheidungen begründbar sein |

Tabelle 1: Kriterien „vertrauenswürdiger KI“ gemäß den Ethischen Leitlinien der EU [2]

Was bedeutet vertrauenswürdig eigentlich?

Über eine einheitliche Definition von Vertrauen wird seit vielen Jahren gestritten. Tatsächlich gibt es darüber mehr wissenschaftliche Artikel als zu irgendeinem anderen soziologischen Begriff. In der zeitgenössischen Vertrauensforschung findet man z.B.: „Vertrauen ist ein zuversichtliches Verhältnis zum Unbekannten.“ [4].

Das Wort „Vertrauen“, das von Menschen auch auf Objekte bezogen werden kann, ist hingegen abzugrenzen vom Adjektiv „vertrauenswürdig“. Diese Eigenschaft wird einer „kompetenten, zuverlässigen, gutwilligen und integren Person“ zugeschrieben [4]. „Vertrauenswürdig“ können aus geisteswissenschaftlicher Perspektive also nur Personen oder Organisationen sein [1].

Wie die Technik zum „Vertrauen“ kam

Woher kommt es dann aber, dass man Technologie das Prädikat „vertrauenswürdig“ zuschreibt? Ursprünge sind in den 1960ger Jahren zu finden, als man technische Systeme vermehrt auf Zuverlässigkeit und „Vertrauenswürdigkeit“ ausrichten wollte. Bei der Übertragung des Konzeptes von Vertrauen in oder auf technische Systeme taten sich zunächst zwei Bedeutungsdimensionen auf:

- Vertrauen von Menschen in die Technik als Objekt

- Vertrauen in Menschen oder Organisationen „hinter“ der Technik

Gerade in den Computerwissenschaften und der Telekommunikation gewann der Wert des Vertrauens in Technologie schnell an Bedeutung. Als Konsequenz kombinierte man schließlich die Eigenschaft „vertrauenswürdig“ zu sein, mit der Technologie selber.

In heutigen Normungsvorhaben von internationalen Normungsverbänden wie z.B. der ISO, wird der KI-Technologie schließlich die Fähigkeit von „Vertrauenswürdigkeit“ zugesprochen. Eine solche Zuschreibung sollte man aber durchaus kritisch betrachten, denn Technologen verstehen darunter lediglich das Vorliegen von bestimmten Merkmalen oder Kriterien.

„künstliches Vertrauen“

Im Jahr 1994 verfasste Stephen Paul Marsh eine einflussreiche Dissertation: „Die Formalisierung von Vertrauen als computergestütztes Konzept“ [5]. Dabei wurde sich erstmalig tiefer mit „künstlichem Vertrauen“ in Systemen verteilter künstlicher Intelligenz auseinandergesetzt.

Marsh stellte damals aber fest: „Das Beste, was wir von emotionslosem Vertrauen erwarten können, ist eine rationale Herangehensweise an das Phänomen.“ Vertrauen sei nicht universell kopier- oder übertragbar, sondern situationsabhängig und kontextsensitiv.

Interessanterweise legte die Arbeit den Grundstein für das sogenannte „Zero–Trust Prinzip“ der IT-Sicherheit, das eher auf dem Gegenteil basiert: Misstrauen. Verdächtig sind für moderne Security Programme ironischerweise vor allen Dingen initiierte Aktionen von der Schwachstelle Nr. 1: dem Menschen hinter dem Gerät. Einen „Vertrauens-Algorithmus“ bedarf es für diese Art Software allerdings nicht.

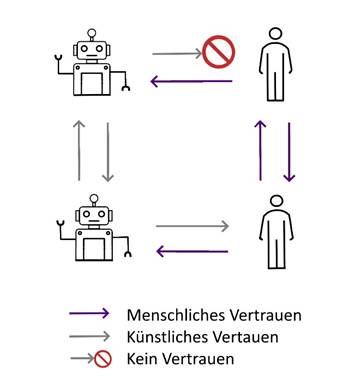

Anders sieht das im Forschungskontext Mensch-KI-Teams aus. KI-Agenten, die mit Menschen kooperieren, bedürfen des „Vertrauens“ der menschlichen Teammitglieder. Reziprok muss aber auch die KI dem Menschen „trauen“ sowie anderen KI-Teammitgliedern. Beim sogenannten „künstlichen Vertrauen“ können nämlich sowohl der Vertrauende (engl. „trustor“) sowie der Gegenstand des Vertrauens (engl. „trustee“) nicht menschlicher Natur sein. Von der technischen Implementierung hängt es also ab, wer künftig vom KI-Agenten im hybriden Team als „vertrauenswürdig“ eingestuft wird.

In der unten abgebildeten Zeichnung ist dargestellt, dass gegenseitiges Vertrauen nicht unbedingt logisch oder konsequent sein muss. Diese Eigenschaft bezeichnet man auch als „nicht transitiv“. Wer im Team wem vertraut, bleibt eine subjektive Einstellung. Spannend ist, wie diese bei KI-Agenten in Software ausgestaltet sein wird.

Spätestens bei Einführung solcher „künstlichen Kollegen“ müssen sich Betriebs- und Personalräte vermehrt ethischen Problemstellungen widmen.

Abbildung 1: Vertrauen bei Mensch-KI-Teams – Vertrauen muss nicht transitiv übertragbar sein

Vertrauenskriterien

Bevor solche hybriden Szenarien Realität werden, muss eine „vertrauenswürdige KI“ aber noch näher spezifiziert werden. Relevante Merkmale und deren Messbarkeit werden derzeit von Experten in Standardisierungsvorhaben nationaler, europäischer oder internationaler Normungsorganisationen wie der DIN, CEN oder ISO zusammengetragen.

Insbesondere in der europäischen Normung lehnt man sich an die Vorgaben aus der KI-Verordnung an. Dort werden zentrale Kriterien ausgestaltet, um KI-Systeme technisch und organisatorisch bewertbar zu machen. Dazu gehören:

- Logging, also das lückenlose Aufzeichnen von Eingaben, Entscheidungen, Änderungen und Interventionspunkten;

- Transparenz, um Systemgrenzen, Einflussfaktoren und Entscheidungswege offenzulegen;

- Menschliche Aufsicht, welche Mechanismen vorsieht, mit denen Menschen eingreifen, übersteuern oder Systeme abschalten können;

- Genauigkeit, mit Anforderungen an Fehlerraten, Bias-Kontrollen und Messmethoden;

- Robustheit, d.h. die Fähigkeit, innerhalb und außerhalb der spezifizierten Einsatzbedingungen stabil zu operieren und gegen Störungen oder Angriffe widerstandsfähig zu sein;

- Cybersicherheit, um Manipulation, Datenlecks oder Angriffe zu verhindern

Diesen Themenbereichen gesellen sich noch weitere Faktoren wie z.B. Datenschutz, Verantwortlichkeit, Zuverlässigkeit oder Benutzerfreundlichkeit hinzu. Aufgrund der Vielfalt ist jedoch bereits klar, dass man nicht alle Kriterien gleichzeitig maximieren kann. Besonders wichtige Faktoren können in bestimmten Applikationen zulasten anderer Merkmale höher gewichtet werden. Ist z.B. Nichtdiskriminierung bei Entscheidungen über Arbeitnehmer essenziell, so müsste eine KI vor Allem auf relevante Fairness-Metriken optimiert sein. „Ultimativ fair“ kann ein Algorithmus aber selbst dann nicht gestaltet werden.

Risikobewertungen als probate Abhilfe

Konsequenterweise widmet man sich deshalb besser dem Umgang von Unsicherheiten und Risiken. Wenn nämlich beides nicht mehr vorliegt, bedarf es auch keines „Vertrauens“ [4].

Betriebs- und Personalräte können Risikobewertungen beim Arbeitgeber oder beim Hersteller anfragen. Empfehlenswerter ist aber die Ausarbeitung einer eigenen Einschätzung. Dies hat den Vorteil, dass die Kriterien der potenziellen Gefahren selbst festgelegt und bewertet werden. In einem solchen Prozess kann z.B. die Wirkung auf Arbeit aus Sicht der Mitarbeitervertretungen quantifiziert werden. Dabei muss der Bewertungsumfang allerdings nicht ausladend sein. Bei geschickter Wahl der Kriterien kann eine erste effektive Risikoabschätzung im Gremium schon in kurzer Zeit durchgeführt werden. Den verbleibenden Problemfeldern kann man sich anschließend gezielt zuwenden und Maßnahmen zur Minderung mit dem Arbeitgeber aushandeln.

Dadurch wird „Vertrauen“ weniger ein wünschenswerter Zustand als vielmehr das Resultat transparenter Abwägung.

Wohlüberlegtes Vertrauensvotum

Die „Vertrauensfrage“ ist zentral, wenn es um Einführung künstlicher Intelligenz in Unternehmen geht. Dem wird die technische Interpretation von „Vertrauenswürdigkeit“ anhand von Merkmalen aber nicht vollends gerecht. Der Vertrauensvorschuss in KI muss jedoch nicht allzu groß ausfallen, wenn Risiken und Folgen der Technologie frühzeitig abschätzt werden. Grundlegend können sich Betriebs- und Personalräte dabei das Prinzip des „Zero—Trust“ zu eigen machen und vom Startpunkt des kritischen Betrachtens die notwendige Akzeptanz in der Organisation vorantreiben.

Vertrauen ist der soziale Kit, der Gesellschaften und Organisationen zusammenhält. Das Vertrauensvotum pro KI sollte also von Mitarbeitervertretern stets wohl überlegt sein.

Quellenangaben

[1] Metzinger, Thomas (Interview). „EU-Ethikrichtlinien für Künstliche Intelligenz: Nehmt der Industrie die Ethik weg!“ Der Tagesspiegel, 8. April 2019

[2] High-Level Expert Group on Artificial Intelligence (AI HLEG). Ethische Leitlinien für eine vertrauenswürdige KI. Veröffentlichung: 8. April 2019.

[3] Laux, Wachter, Mittelstadt (2024). “Vertrauenswürdige künstliche Intelligenz und der EU AI Act: Über die Vermischung von Vertrauenswürdigkeit und Risikobereitschaft.”

[4] Botsman, Rachel (2020). Wem kannst du trauen? – Die Antwort auf die vielleicht wichtigste Frage unserer Zeit.

[5] Original: Marsh, Stephen Paul (1994). Formalising Trust as a Computational Concept. PhD Thesis, University of Stirling.